아틀란티스의 상공에 출렁이는 바다 또는 금융 머신러닝

땅끝

2025-01-04 07:51

513

0

본문

아틀란티스의 상공에 출렁이는 바다

도서명 : 아틀란티스의 상공에 출렁이는 바다

저자/출판사 : 중국연변조선족자치주조선족아동문학학회, 한국학술정보

쪽수 : 226쪽

출판일 : 2022-01-15

ISBN : 9791168011977

정가 : 14700

권두언

동심에서 샘솟는 아동문학, 그 거룩함 앞에서/김현순/8

소 설

고갯길/신철국/10

엄마의 발/윤옥자/19

이빨은 하얗게 빛났다/김미란/22

안녕, 아빠/손예경/31

밤하늘/박룡원/37

나 홀로 라라라/김만석/44

오누이와 개구리/허두남/53

동 화

아틀란티스의 상공에 출렁이는 바다/김현순/62

악마 돌이의 전설/이강산/70

밤중에 울린 sos/권순복/75

맷돌이네 쌍둥이형제/강성범/79

뱃속의 소리/박경화/84

개미의 바다구경/정문준/91

동 시

강효삼 시 한바구니/100

바다의 개구쟁이(외 5수)/김동진/105

그 품이 제일 좋아요(외 3수)/한동해/109

똑같애(외 4수)/김득만/113

화가(외 3수)/최화길/117

봄꿈은 동심이어라/홍순범/120

기적소리(외 4수)/황희숙/121

동년(외 6수)/윤옥자/124

봄비(외 4수)/이순희/128

매화꽃(외 2수)/신현희/131

잎새(외 7수)/김소연/133

조혜선 동시 한묶음/139

도와주다(외 4수)/강 려/145

바다(외 4수)/김봉순/149

올챙이 계절에(외 1수)/정두민/153

봄과 씨앗(외 7수)/신정국/155

맥주잔(외 2수)/신현준/160

칫솔(외 2수)/류송미/162

노을(외 2수)/김다정/164

밤에 피는 꽃(외 1수)/신금화/167

평 론

아동문학의 독자대상과 장르 및스토리의 경지에 대하여/백천만/169

이야기 · 수기 · 수필

아, 별처럼 빛나는 추억의 사금파리들/김하나/182

피를 물고 울던 새는 어디로 갔나?/권중철/190

“통신원”의 실수/김소연/197

아버지란 그 이름은/박영희/204

사춘기, 못난 뿔에 피어난 향기/표영란/209

우 화

고양이형제(외 1편)/와 룡/212

편집후기/217

금융 머신러닝

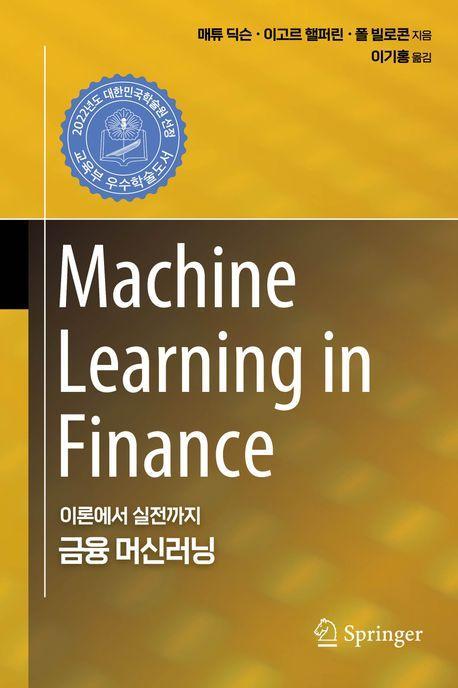

도서명 : 금융 머신러닝

저자/출판사 : 매튜 딕슨 , 이고르 핼퍼린 , 폴 빌로콘, 에이콘출판

쪽수 : 804쪽

출판일 : 2022-01-11

ISBN : 9791161755939

정가 : 60000

1부. 횡단면 데이터를 사용한 머신러닝

1장. 정보 이론 입문

1. 배경

1.1 빅데이터: 금융 분야의 빅 컴퓨팅

1.2 핀테크

2. 머신러닝과 예측

2.1 엔트로피

2.2 신경망

3. 통계 모델링과 머신러닝

3.1 모델링 패러다임

3.2 금융 계량경제학과 머신러닝

3.3 과적합

4. 강화학습

5. 지도 머신러닝 실제 사례

5.1 알고리듬 트레이딩

5.2 고빈도 트레이드 실행

5.3 모기지 모델링

6. 요약

7. 연습문제

부록

참고 문헌

2장. 확률 모델링

1. 서론

2. 베이지안 대 빈도주의 추정

3. 데이터로부터 빈도주의 추정

4. 추정량의 품질 평가: 편향과 분산

5. 추정량에 대한 편향-분산 트레이드오프(딜레마)

6. 데이터로부터 베이지안 추론

6.1 더 정보성이 큰 사전분포: 베타 분포

6.2 순차적 베이지안 업데이트

6.3 고전적 또는 베이지안 추정 프레임워크 선택의 실무적 의미

7. 모델 선택

7.1 베이지안 추론

7.2 모델 선택

7.3 많은 모델이 있을 때 모델 선택

7.4 오캠의 면도날

7.5 모델 평균화

8. 확률적 그래프 모델

8.1 혼합 모델

9. 요약

10. 연습문제

부록

참고 문헌

3장. 베이지안 회귀와 가우시안 프로세스

1. 서론

2. 선형회귀를 활용한 베이지안 추론

2.1 최대 우도 추정

2.2 베이지안 예측

2.3 슈어 항등식

3. 가우시안 프로세스 회귀

3.1 금융에서 가우시안 프로세스

3.2 가우시안 프로세스 회귀와 예측

3.3 하이퍼파라미터 튜닝

3.4 계산 특성

4. 대규모 확장 가능 가우시안 프로세스

4.1 구조 커널 보간(SKI)

4.2 커널 근사

5. 예제: 단일 GP를 활용한 가격 결정과 그릭 계산

5.1 그릭 계산

5.2 메시 프리 GP

5.3 대규모 확장 가능 GP

6. 다중 반응 가우시안 프로세스

6.1 다중 출력 가우시안 프로세스 회귀와 예측

7. 요약

8. 연습문제

8.1 프로그래밍 연관 문제

부록

참고 문헌

4장. 순전파 신경망

1. 서론

2. 순전파 구조

2.1 예비지식

2.2 순전파 네트워크의 기하학적 해석

2.3 확률적 추론

2.4 딥러닝을 활용한 함수 근사*

2.5 VC 차원

2.6 신경망이 스플라인인 경우

2.7 왜 심층 네트워크를 사용하는가?

3. 볼록성과 부등식 제약식

3.1 MLP와 다른 지도학습기와의 유사성

4. 훈련, 검증, 테스트

5. 확률적 그래디언트 하강법(SGD)

5.1 역전파

5.2 모멘텀

6. 베이지안 신경망*

7. 요약

8. 연습문제

8.1 프로그래밍 연관 문제*

부록

참고 문헌

5장. 해석 가능성

1. 서론

2. 해석 가능성에 대한 배경

2.1 민감도

3. 신경망의 설명력

3.1 다중 은닉층

3.2 예제: 스텝 테스트

4. 상호작용 효과

4.1 예제: 프리드만 데이터

5. 자코비안 분산에 대한 상한

5.1 체르노프 상한

5.2 시뮬레이션 예제

6. 팩터 모델링

6.1 비선형 팩터 모델

6.2 펀더멘털 팩터 모델링

7. 요약

8. 연습문제

8.1 프로그래밍 연관 문제

부록

참고 문헌

2부. 순차적 학습

6장. 시퀀스 모델링

1. 서론

2. 자기회귀 모델링

2.1 예비지식

2.2 자기회귀 프로세스

2.3 안정성

2.4 정상성

2.5 편자기상관관계

2.6 최대 우도 추정

2.7 이분산성

2.8 이동 평균 프로세스

2.9 GARCH

2.10 지수 평활화

3. 시계열 모델 적합화: 박스-젠킨스 접근법

3.1 정상성

3.2 정상성을 보장하는 변환

3.3 식별

3.4 모델 진단

4. 예측

4.1 예측 이벤트

4.2 시계열 교차 검증

5. 주성분 분석

5.1 주성분 투영

5.2 차원 축소

6. 요약

7. 연습문제

부록

참고 문헌

7장. 확률적 시퀀스 모델

1. 서론

2. 은닉 마르코프 모델링

2.1 비터비 알고리듬

2.2 상태-공간 모델

3. 입자 필터링

3.1 순차적 중요도 리샘플링(SIR)

3.2 다항 리샘플링

3.3 응용: 확률적 변동성 모델

4. 확률적 필터의 점 보정

5. 확률적 필터의 베이지안 보정

6. 요약

7. 연습문제

부록

참고 문헌

8장. 고급 신경망

1. 서론

2. 순환 신경망

2.1 RNN 메모리: 편자기공분산

2.2 안정성

2.3 정상성

2.4 일반화된 신경망(GRNN)

3. GRU

3.1 α-RNNs

3.2 신경망 지수 평활화

3.3 LSTM

4. 파이썬 노트북 예제

4.1 비트코인 예측

4.2 지정가 주문 호가창으로부터 예측

5. 합성곱 신경망

5.1 가중 이동 평균 평활기

5.2 2D 합성곱

5.3 풀링

5.4 팽창 합성곱

5.5 파이썬 노트북

6. 오토인토더

6.1 선형 오토인코더

6.2 선형 오토인코더와 PCA의 동등성

6.3 딥 오토인코더

7. 요약

8. 연습문제

8.1 프로그래밍 관련 질문*

부록

참고 문헌

3부. 순차적 데이터와 의사결정

9장 강화학습 소개

1. 서론

2. 강화학습의 요소

2.1 보상

2.2 가치와 정책 함수

2.3 관측 가능 대 부분 관측 가능 환경

3. 마르코프 의사결정 프로세스

3.1 의사결정 정책

3.2 가치 함수와 벨만 방정식

3.3 최적 정책과 벨만 최적성

4. 동적 프로그래밍 방법

4.1 정책 평가

4.2 정책 반복

4.3 가치 반복

5. 강화학습법

5.1 몬테카를로 방법

5.2 정책 기반 학습

5.3 시간 차이 학습

5.4 SARSA와 Q 러닝

5.5 확률 근사와 배치 모드 Q 러닝

5.6 연속 공간에서의 Q 러닝: 함수근사

5.7 배치 모드 Q 러닝

5.8 최소 자승 정책 반복

5.9 심층 강화학습

6. 요약

7. 연습문제

부록

참고 문헌

10장. 강화학습 응용

1. 서론

2. 옵션 가격 결정을 위한 QLBS

3. 이산 시간 블랙-숄즈-머튼 모델

3.1 헷징 포트폴리오 평가

3.2 최적 헷징 전략

3.3 이산 시간에서의 옵션 가격 결정

3.4 BS 극한에서의 헷징과 가격 결정

4. QLBS 모델

4.1 상태 변수

4.2 벨만 방정식

4.3 최적 정책

4.4 DP 해: 몬테카를로 구현

4.5 QLBS에 대한 RL 해: 적합화된 Q 반복(FQI)

4.6 예제

4.7 옵션 포트폴리오

4.8 가능한 확장

5. 주식 포트폴리오를 위한 G-러닝

5.1 서론

5.2 투자 포트폴리오

5.3 최종 조건

5.4 자산 수익률 모델

5.5 시그널 동학과 상태 공간

5.6 1기간 보상

5.7 다기간 포트폴리오 최적화

5.8 확률적 정책

5.9 준거 정책

5.10 벨만 최적 방정식

5.11 엔트로피 규제화 벨만 최적성 방정식

5.12 G-함수: 엔트로피 규제화 Q 함수

5.13 G-러닝과 F-러닝

5.14 시장 충격을 가진 포트폴리오 동학

5.15 제로 함수 극한: 엔트로피 규제화를 가진 LQR

5.16 영이 아닌 시장 충격: 비선형 동학

6. 자산 관리를 위한 RL

6.1 머튼 소비 문제

6.2 확정 기여형 퇴직 플랜을 위한 포트폴리오 최적화

6.3 은퇴 플랜 최적화를 위한 G-러닝

6.4 논의

7. 요약

8. 연습문제

부록

참고 문헌

11장. 역강화학습과 모방학습

1. 서론

2. 역강화학습

2.1 RL 대 IRL

2.2 IRL의 성공 기준은 무엇인가?

2.3 진정으로 전이 가능한 보상 함수가 IRL로 학습될 수 있을까?

3. 최대 엔트로피 역강화학습

3.1 최대 엔트로피 원리

3.2 최대 인과 엔트로피

3.3 G-러닝과 소프트 Q 러닝

3.4 최대 엔트로피 IRL

3.5 분배 함수 추정

4. 예제: 소비자 선호 추론을 위한 MaxEnt IRL

4.1 IRL과 소비자 선택 문제

4.2 소비자 효용 함수

4.3 소비자 효용을 위한 최대 엔트로피 IRL

4.4 데이터가 얼마나 필요한가? IRL과 관측 잡음

4.5 반사실적 시뮬레이션

4.6 MLE 추정량의 유한-샘플 속성

4.7 논의

5. 적대적 모방학습과 IRL

5.1 모방학습

5.2 GAIL: 적대적 생성 모방학습

5.3 IRL에서 RL을 우회하는 기술로서의 GAIL

5.4 GAIL에서의 실제적 규제화

5.5 GAIL에서의 적대적 학습

5.6 다른 적대적 접근법*

5.7 f-발산 훈련*

5.8 와서스타인 GAN*

5.9 최소 제곱 GAN*

6. GAIL을 넘어: AIRL, f-MAX, FAIRL, RS-GAIL 등*

6.1 AIRL: 적대적 역강화학습

6.2 전방 KL 또는 후방 KL?

6.3 f-MAX

6.4 순방향 KL: FAIRL

6.5 리스크 민감 GAIL(RS-GAIL)

6.6 요약

7. 가우시안 프로세스 역강화학습

7.1 베이지안 IRL

7.2 가우시안 프로세스 IRL

8. IRL은 교사를 능가할 수 있을까?

8.1 실패로부터의 IRL

8.2 학습 선호

8.3 T-REX: 경로-순위 보상 외삽

8.4 D-REX: 교란-기반 보상 외삽

9. 금융 절벽 걷기를 위한 IRL의 시도

9.1 최대 인과 엔트로피 IRL

9.2 실패로부터 IRL

9.3 T-REX

9.4 요약

10. IRL의 금융 응용

10.1 알고리듬 트레이딩 전략 식별

10.2 옵션 가격 결정을 위한 역강화학습

10.3 G-러닝과 포트폴리오 투자가의 IRL

10.4 감성 기반 트레이딩 전략을 위한 IRL과 보상학습

10.5 IRL과 ‘보이지 않는 손’ 추론

11. 요약

12. 연습문제

부록

참고 문헌

12장. 머신러닝과 금융의 최전선

1. 서론

2. 시장 동학, 역강화학습과 물리학

2.1 ‘퀀텀 균형-불균형’(QED) 모델

2.2 랑주뱅 방정식

2.3 랑주뱅 방정식으로서 GBM 모델

2.4 랑주뱅 방정식으로서 QED 모델

2.5 금융 모델링에 대한 통찰력

2.6 머신러닝에 대한 통찰력

3. 물리학과 머신러닝

3.1 딥러닝과 물리학에서의 계층적 표현

3.2 텐서 네트워크

3.3 불균형 환경에서의 제한된 합리적 에이전트

4. 머신러닝의 ‘대통합’

4.1 인지-행동 주기

4.2 정보 이론과 강화학습의 접점

4.3 강화학습과 지도학습: 예측, MuZero와 다른 새로운 아이디어

참고 문헌

댓글목록0